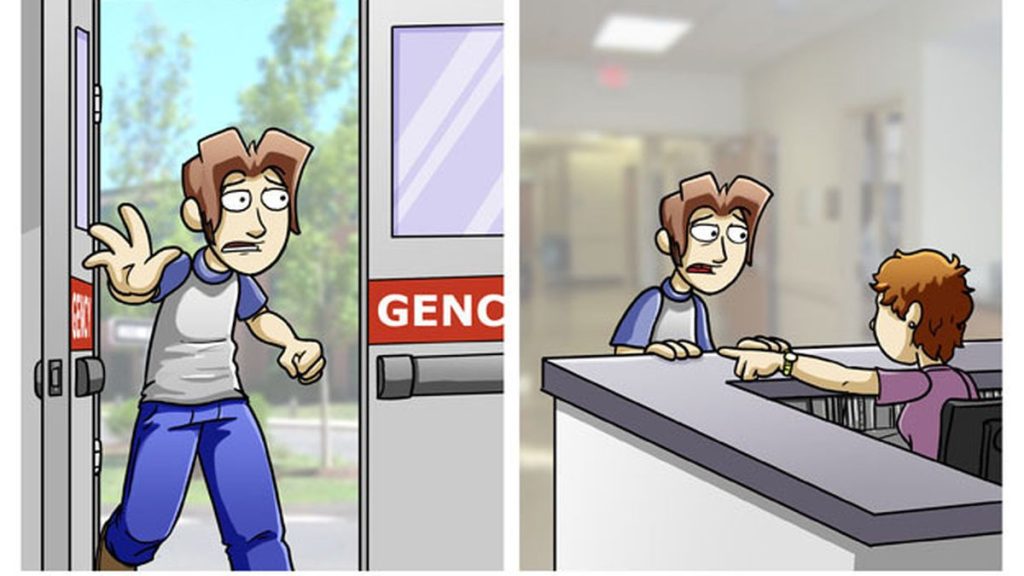

Is This Loss The Sad Comic That Turned Into A Historic Meme

Loss Comic Memes Piñata Farms The Best Meme Generator And Meme 看题主的意思,应该是想问,如果用训练过程当中的loss值作为衡量深度学习模型性能的指标的话,当这个指标下降到多少时才能说明模型达到了一个较好的性能,也就是将loss作为一个evaluation metrics。 但是就像知乎er们经常说的黑话一样,先问是不是,再问是什么。所以这个问题有一个前提,就是. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell 2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,它会倾向于让特征向量的范数变得非常大。.

Loss Comic Meme Explained 2024 Viral Meme Meaning Explained Loss surfaces of a resnet 56 (li et al, 2018) 很可能预训练的大型语言模型在接近最小损失的区域具有非常平滑的损失面,而开源社区在这一区域进行的大量微调工作。 这基于围绕2018年ulmfit论文原始开发通用语言模型的前提。. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和 hinge 损失。. 1.3 cross entropy loss function(交叉熵损失函数) 1.3.1 表达式 (1) 二分类 在二分的情况下,模型最后需要预测的结果只有两种情况,对于每个类别我们的预测得到的概率为 和 ,此时表达式为( 的底数是 ): 其中: —— 表示样本 的label,正类为 ,负类为. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个过程也是机器学习中的精髓,好的损失函数既可以反映模型的训练误差,也可以反映模型的泛化误差,可参考以下几种思路: 首先就是.

Loss Meme Copypastatext 1.3 cross entropy loss function(交叉熵损失函数) 1.3.1 表达式 (1) 二分类 在二分的情况下,模型最后需要预测的结果只有两种情况,对于每个类别我们的预测得到的概率为 和 ,此时表达式为( 的底数是 ): 其中: —— 表示样本 的label,正类为 ,负类为. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个过程也是机器学习中的精髓,好的损失函数既可以反映模型的训练误差,也可以反映模型的泛化误差,可参考以下几种思路: 首先就是. 多任务学习中各loss权重应该如何设计呢? 多任务学习中,会存在多个网络部分,对应多个loss。 看论文通常是把各loss统一到同一个数量级上,请问这么做的原理是什么? 为什么一般不考虑不同网络部分… 显示全部 关注者 2,026 被浏览. 这里: y 是二元标签,要么是0要么是1。 p 是模型预测为1的概率。 交叉熵损失通过这样的数学形式,有效地衡量了模型输出和真实标签之间的差异,成为优化分类器的关键。在实际训练过程中,我们通过不断迭代模型参数来最小化这个损失值,从而提高模型的准确性。 回到二个问题:和transformer预. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们只对边界上的像素进行评估,和gt的边界吻合则为0,不吻合的点,根据其距离边界的距离评估它的loss。. 深度学习中loss值可以为负吗? 修改了一下mse损失函数,发现模型的表现明显变好了,但是loss值出现了负值,请问这样正常吗.

He Started The Loss Meme Before The Comic Was Even Made Dank Memes Amino 多任务学习中各loss权重应该如何设计呢? 多任务学习中,会存在多个网络部分,对应多个loss。 看论文通常是把各loss统一到同一个数量级上,请问这么做的原理是什么? 为什么一般不考虑不同网络部分… 显示全部 关注者 2,026 被浏览. 这里: y 是二元标签,要么是0要么是1。 p 是模型预测为1的概率。 交叉熵损失通过这样的数学形式,有效地衡量了模型输出和真实标签之间的差异,成为优化分类器的关键。在实际训练过程中,我们通过不断迭代模型参数来最小化这个损失值,从而提高模型的准确性。 回到二个问题:和transformer预. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们只对边界上的像素进行评估,和gt的边界吻合则为0,不吻合的点,根据其距离边界的距离评估它的loss。. 深度学习中loss值可以为负吗? 修改了一下mse损失函数,发现模型的表现明显变好了,但是loss值出现了负值,请问这样正常吗.

Loss Comic Drawception 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们只对边界上的像素进行评估,和gt的边界吻合则为0,不吻合的点,根据其距离边界的距离评估它的loss。. 深度学习中loss值可以为负吗? 修改了一下mse损失函数,发现模型的表现明显变好了,但是loss值出现了负值,请问这样正常吗.

Comments are closed.